hugging face基础入门——evaluate库的使用

创作时间:

作者:

@小白创作中心

hugging face基础入门——evaluate库的使用

引用

CSDN

1.

https://blog.csdn.net/weixin_56696781/article/details/144017236

内容前置

本系列下内容为跟随b站课程总结 课程链接:

【手把手带你实战HuggingFace Transformers】

本节内容主要是evaluate库的一些操作并修改之前编写的部分评估代码。

evaluate库的使用

首先我们可以通过下面方法查看evaluate支持的评估函数:

import evaluate

evaluate.list_evaluation_modules()

输出结果为

['Remeris/rouge_ru',

'hage2000/code_eval_stdio',

'lvwerra/test',

'jordyvl/ece',

'angelina-wang/directional_bias_amplification',

'cpllab/syntaxgym',

'lvwerra/bary_score',

'hack/test_metric',

'yzha/ctc_eval',

'codeparrot/apps_metric',

'mfumanelli/geometric_mean',

'daiyizheng/valid',

'erntkn/dice_coefficient',

'mgfrantz/roc_auc_macro',

'Vlasta/pr_auc',

'gorkaartola/metric_for_tp_fp_samples',

'idsedykh/metric',

'idsedykh/codebleu2',

'idsedykh/codebleu',

'idsedykh/megaglue',

'christopher/ndcg',

'Vertaix/vendiscore',

'GMFTBY/dailydialogevaluate',

'GMFTBY/dailydialog_evaluate',

'jzm-mailchimp/joshs_second_test_metric',

...

'lsy641/distinct',

'grepLeigh/perplexity',

'Charles95/element_count',

'Charles95/accuracy',

'Lucky28/honest']

这里我们加载下常用的accuracy看下

acc = evaluate.load("accuracy")

acc

输出结果为

EvaluationModule(name: "accuracy", module_type: "metric", features: {'predictions': Value(dtype='int32', id=None), 'references': Value(dtype='int32', id=None)}, usage: """

Args:

predictions (`list` of `int`): Predicted labels.

references (`list` of `int`): Ground truth labels.

normalize (`boolean`): If set to False, returns the number of correctly classified samples. Otherwise, returns the fraction of correctly classified samples. Defaults to True.

sample_weight (`list` of `float`): Sample weights Defaults to None.

Returns:

accuracy (`float` or `int`): Accuracy score. Minimum possible value is 0. Maximum possible value is 1.0, or the number of examples input, if `normalize` is set to `True`.. A higher score means higher accuracy.

Examples:

Example 1-A simple example

>>> accuracy_metric = evaluate.load("accuracy")

>>> results = accuracy_metric.compute(references=[0, 1, 2, 0, 1, 2], predictions=[0, 1, 1, 2, 1, 0])

>>> print(results)

{'accuracy': 0.5}

Example 2-The same as Example 1, except with `normalize` set to `False`.

>>> accuracy_metric = evaluate.load("accuracy")

>>> results = accuracy_metric.compute(references=[0, 1, 2, 0, 1, 2], predictions=[0, 1, 1, 2, 1, 0], normalize=False)

>>> print(results)

{'accuracy': 3.0}

Example 3-The same as Example 1, except with `sample_weight` set.

>>> accuracy_metric = evaluate.load("accuracy")

>>> results = accuracy_metric.compute(references=[0, 1, 2, 0, 1, 2], predictions=[0, 1, 1, 2, 1, 0], sample_weight=[0.5, 2, 0.7, 0.5, 9, 0.4])

>>> print(results)

{'accuracy': 0.8778625954198473}

""", stored examples: 0)

我们可以看到里面提供了具体参数及样例使用从而帮助我们理解。

但我们数据往往是逐步按批次处理的,那么我们就得奖代码改写为:

#流式数据处理

for pred,truth in zip([1,1,1,0,1],[1,0,1,1,1]):

acc.add(prediction=pred,reference=truth)

acc.compute()

#输出为{'accuracy': 0.6}

#批次数据处理

for batch_pre,batch_tru in [[[1,1,0],[1,0,0]],[[1,1,1],[0,1,0]]]:

print(batch_pre)

print(batch_tru)

acc.add_batch(predictions=batch_pre,references=batch_tru)

acc.compute()

#输出为[1, 1, 0]

# [1, 0, 0]

# [1, 1, 1]

# [0, 1, 0]

#{'accuracy': 0.5}

第一种方法(

acc.add(prediction=..., reference=...)

)更适合实时处理数据,逐步计算每个预测值和真实值的准确率。它可以在训练的每一个小批次中逐步更新结果。

第二种方法(

acc.add_batch(predictions=..., references=...)

)则更适合一次性处理一个批次的数据,通常在训练模型时会使用批量数据,因此这种方式更加高效,尤其是在计算多个样本的准确率时。

当我们需要使用多种评估函数时我们使用自带的combine函数:

combines = evaluate.combine(["accuracy","f1","recall","precision"])

combines_result_1 = combines.compute(predictions=[1,1,0,0],references=[1,0,1,0])

combines_result_1

输出为:

{'accuracy': 0.5, 'f1': 0.5, 'recall': 0.5, 'precision': 0.5}

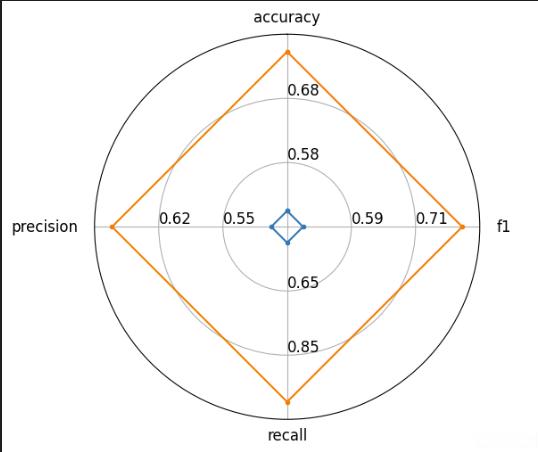

为了更好理解模型之前性能区别,evaluate还提供了radar_plot函数为我们绘制雷达图,这里我随意据两个案例说明:

combines_result_1 = combines.compute(predictions=[1,1,0,0],references=[1,0,1,0])

#输出为{'accuracy': 0.5, 'f1': 0.5, 'recall': 0.5, 'precision': 0.5}

combines_result_2 = combines.compute(predictions=[1,1,1,0],references=[1,0,1,0])

#输出为{'accuracy': 0.75, 'f1': 0.8, 'recall': 1.0, 'precision': 0.6666666666666666}

from evaluate.visualization import radar_plot

data = [

combines_result_1,

combines_result_2

]

model_names = ["model1","model2"]

plot = radar_plot(data,model_names=model_names)

输出雷达图为:

原函数修改

学习了evaluate库之后,我们可以对hingingface基础入门——小模型全量微调-CSDN博客中评估函数进行修改并增加,原函数为:

def eval():

model.eval()

acc = 0

with torch.no_grad(): # 推理模式

for batch in validloader:

if torch.cuda.is_available():

batch = {k: v.cuda() for k, v in batch.items()}

output = model(**batch)

pred = torch.argmax(output.logits, dim=-1)

acc += (pred == batch["labels"]).float().sum().item() # 累计正确预测数

return acc / len(validset)

修改后函数为:

combines = evaluate.combine(["accuracy","f1"])

def eval():

model.eval()

acc = 0

with torch.no_grad(): # 推理模式

for batch in validloader:

if torch.cuda.is_available():

batch = {k: v.cuda() for k, v in batch.items()}

output = model(**batch)

pred = torch.argmax(output.logits, dim=-1)

combines.add(prediction==pred,reference=bath["labels"])

return combines.compute()

如有讲解不周到之初,欢迎指出交流,请大家多多包涵

热门推荐

如何区分直角、锐角和钝角?

最简单方便实现Ubuntu远程桌面的方法

患者体验与满意度:在线问诊系统的影响与反馈

如何选择黄金ETF或贵金属的投资方向?这种选择依据哪些市场条件和因素?

黄金ETF的结构如何影响投资成本?这种成本对投资者决策有何影响?

水边草本花卉有哪些

电池容量技术创新引领新能源汽车产业发展

公司辞退要怎么离职证明

信号发生器在电子设备浪涌测试中的应用

这种“三高”水果,我劝你多吃点

家庭与学校联手:青少年体质提升的关键在于共同努力

安卓如何关闭设备管理软件

房梁钉钉子影响风水吗

开盘15分钟走势分析:高开、低开、平开全解析

催吐对身体的危害:多久算频繁?真的能减肥吗?

雅马哈巧格i125省油?真实路测揭秘

冬季高发的慢性鼻炎,这些预防与护理技巧你做对了吗?

复读生的困境,2025年浙江高考复读限制深度剖析

解析典型传销案例特点分析报告:深层法律剖析与应对策略

夫妻口头协议有效吗

欠钱不还起诉指南:案由选择、诉讼费用与强制措施详解

网络工程师和运维工程师有什么区别

蝴蝶兰“爱吃”一种肥,每月“喂”一次,叶绿花又艳,花苞满枝头

物质结构与性质:金属晶体、离子晶体及过渡晶体详解

Nature重磅:AI帮助发现人体内天然减肥分子,媲美司美格鲁肽且无常见副作用

富兰克林的智慧:避免争辩,巧妙解决问题,发掘人性

Ubuntu进入root权限的三种方法

银行同业拆借业务的风险控制策略

企业间拆借资金怎样做才属合法

苹果树选址与土壤准备:为成功种植打下基础