机器学习:数据预处理——数据清洗

创作时间:

作者:

@小白创作中心

机器学习:数据预处理——数据清洗

引用

CSDN

1.

https://m.blog.csdn.net/weixin_65047977/article/details/142035173

数据清洗是机器学习数据预处理中的关键步骤,它涉及去除重复数据、处理缺失值、统一数据格式、纠正数据错误、处理异常值等多个环节。本文通过一个矿物数据集的实例,详细介绍了数据清洗的具体步骤和Python代码实现,帮助读者更好地理解和掌握这一重要环节。

一、数据清洗

1.数据清洗是什么

数据清洗是指在数据分析过程中,对原始数据进行处理和整理的过程,以提高数据的质量和可用性。这是数据预处理中的一个关键步骤。

2.数据清洗步骤

- 去除重复数据:识别并删除重复记录。

- 处理缺失值:填补缺失值或删除包含缺失值的记录。

- 统一数据格式:统一数据格式,如日期、时间或数值单位。

- 纠正数据错误:修正数据中的错误和不一致,如拼写错误或错误的分类。

- 处理异常值:检测和处理数据中的异常值或离群点。

- 数据一致性检查:确保数据在不同数据源或表之间的一致性。

- 数据转换:将数据转换成适合分析的格式,例如归一化、编码分类变量等。

3.数据清洗示例

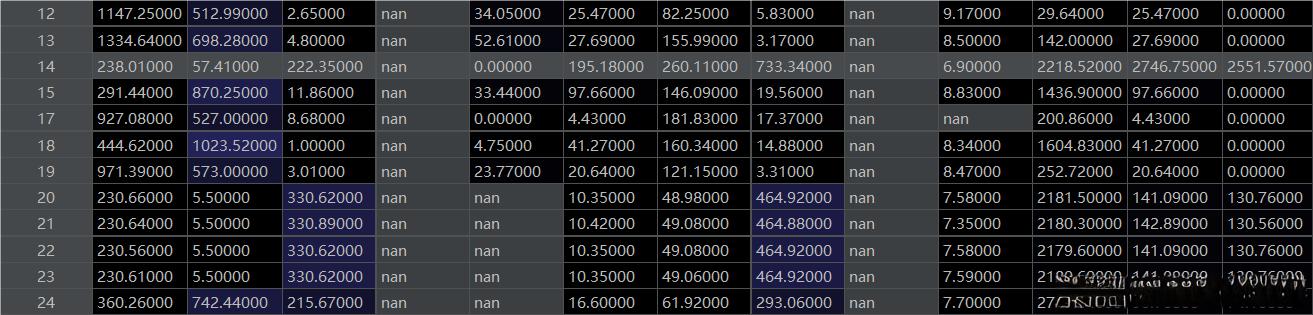

- 图片只截取了部分数据做演示

- 原始数据

- 经过数据清洗之后的数据

- 可以看到缺失值都进行了填充,特殊符号进行了去除,数据进行了z标准化的转换

二、数据清洗代码实现

1.完整代码

import pandas as pd

import fill_data

data = pd.read_excel('矿物数据.xls') # 导入数据

data = data[data['矿物类型'] != 'E'] # 去除数据量很少的类别

null_num = data.isnull()

# isnull() 会返回一个相同形状的DataFrame,但其中的元素是布尔值(True或False)。

# 如果原始DataFrame中的某个位置是缺失值(通常是NaN,即"Not aNumber”),

# 则对应位置在返回的DataFrame中会被标记为True;否则,标记为False。

# 注:还有空白处也是nan,isnull未包含空自处。

null_total = null_num.sum() # 检测每一列的缺失值个数

x_whole = data.iloc[:, 1:-1] # 取出特征数据

y_whole = data['矿物类型'] # 取出标签数据

# 将数据中的中文标签转换为字符

label_dict = {"A": 0, "B": 1, "C": 2, "D": 3}

encode_labels = [label_dict[label] for label in y_whole] # 将y_whole中的字母转换成数字并储存在列表里

y_whole = pd.Series(encode_labels, name='矿物类型') # 将原本的y_whole替换成encode_labels

# 数据中存在大量字符串数值、|、空格等异常数据。字符串数值直接转换为float,\和空格转换为nan

for column_name in x_whole.columns:

x_whole[column_name] = pd.to_numeric(x_whole[column_name], errors='coerce')

# pd.to_numeric()函数尝试将参数中的数据转换为数值类型。如果转换失败,它会引发一个异常

# 设置errors='coerce',会将无法转换的值设置为NaN

"""-----------------数据标准化: Z标准化-------------"""

from sklearn.preprocessing import StandardScaler

std = StandardScaler()

x_whole_z = std.fit_transform(x_whole) # 转换之后储存在矩阵里

x_whole = pd.DataFrame(x_whole_z, columns=x_whole.columns) # z标准化处理后为numpy数据,这里再转换成pandas数据

2.代码步骤解析

1.导入库和数据

初步去除异常数据:

在这份数据里,分类为E的数据只有一条,无法使用,直接去除

import pandas as pd

import fill_data

data = pd.read_excel('矿物数据.xls') # 导入数据

data = data[data['矿物类型'] != 'E'] # 去除数据量很少的类别

2.检测有无缺失值

null_num = data.isnull()

# isnull() 会返回一个相同形状的DataFrame,但其中的元素是布尔值(True或False)。

# 如果原始DataFrame中的某个位置是缺失值(通常是NaN,即"Not aNumber”),

# 则对应位置在返回的DataFrame中会被标记为True;否则,标记为False。

# 注:还有空白处也是nan,isnull未包含空自处。

null_total = null_num.sum() # 检测每一列的缺失值个数

输出:

将数据的列名和该列有多少失值存入Series类型数据

3.标签数字化

- 取出特征数据和标签数据

- 将标签数据中的字母转换成数字

x_whole = data.iloc[:, 1:-1] # 取出特征数据

y_whole = data['矿物类型'] # 取出标签数据

# 将数据中的中文标签转换为字符

label_dict = {"A": 0, "B": 1, "C": 2, "D": 3}

encode_labels = [label_dict[label] for label in y_whole] # 将y_whole中的字母转换成数字并储存在列表里

y_whole = pd.Series(encode_labels, name='矿物类型') # 将原本的y_whole替换成encode_labels

4.去除异常数据

- 将字符串类型数据转换成数值类型

- 特殊符号或者空格转换成nan

# 数据中存在大量字符串数值、|、空格等异常数据。字符串数值直接转换为float,\和空格转换为nan

for column_name in x_whole.columns:

x_whole[column_name] = pd.to_numeric(x_whole[column_name], errors='coerce')

# pd.to_numeric()函数尝试将参数中的数据转换为数值类型。如果转换失败,它会引发一个异常

# 设置errors='coerce',会将无法转换的值设置为NaN

输出:

5.标准化数据

- 将数据进行z标准化

- 得到的结果是矩阵

- 将其转换成DF表格数据

"""-----------------数据标准化: Z标准化-------------"""

from sklearn.preprocessing import StandardScaler

std = StandardScaler()

x_whole_z = std.fit_transform(x_whole) # 得到的结果是矩阵

x_whole = pd.DataFrame(x_whole_z, columns=x_whole.columns) # z标准化处理后为numpy数据,这里再转换成pandas数据

输出:

总结

至此数据清洗已经完成了大部分,剩下缺失值填充的几种方法将在下一篇进行介绍

热门推荐

天然亮肤秘诀:姜黄蜂蜜柠檬面膜

情绪导航者,引领青少年穿越情绪风暴

失眠救星思诺思:快速入睡的秘密,但长期使用需警惕!

广州徒步线路推荐,广州6大免费徒步圣地,天晴就出发

标准品在分析检测中的应用及使用注意事项

类脑计算方法上新!“基于内生复杂性”AI模型运算效率显著提升

近视手术术后复查全攻略:时间安排、检查内容及注意事项

清华大学车辆与运载学院研究成果:智能网联汽车情感化交互发展回顾与展望

1994年的那场灾难,幸亏木星的挺身而出,地球才逃过了一劫

青岛2025年春节假期交通出行提示,车流量分析易拥点预警

如何分析企业的盈利模式?这些分析方法有哪些实际应用?

一元论与二元论:认知世界的两种基本观点

医院级别划分标准及常见类型解析

泉州青年学子助力“非遗”传承,赋能文旅融合

为什么猫咪会吐毛球?5种减少猫咪吐毛球的预防方式

李力行:2025年的经济压力与财政应对要点

【健康科普】科学防控 谨防职业中毒

越发动机状况如何?如何保养该发动机?

宁波天一阁:历史的积淀与文化的展望

执业中药师的在线继续教育与职业晋升路径

小说标题的作用 如何分析小说标题含义

乳腺癌治疗费用详解:从手术到医保报销全攻略

手动修改住房租金专项附加扣除信息后,导致前三个月数据消失,怎么办?

扬州美食之城,隐藏在街头巷尾的八大特色美食,让人回味无穷

利用数据分析,连锁药店会员管理软件的深度应用

AI信任危机之后,揭秘预训练如何塑造机器的“可信灵魂”

罗翔言论翻车风波升级,更多争议言论被扒,多位知名大V下场开撕

Matlab simulink建模与仿真 第八章(数学运算库)【下】

回避型人格在感情中的十大表现及相处建议

《哪吒》导演饺子,一个“疯子”的18年死磕