【LLM大模型】拆解LangChain的大模型记忆方案

【LLM大模型】拆解LangChain的大模型记忆方案

简介:之前我们聊过如何使用LangChain给LLM(大模型)装上记忆,里面提到对话链ConversationChain和MessagesPlaceholder,可以简化安装记忆的流程。下文来拆解基于LangChain的大模型记忆方案。

之前我们聊过如何使用LangChain给LLM(大模型)装上记忆,里面提到对话链

ConversationChain

和

MessagesPlaceholder

,可以简化安装记忆的流程。下文来拆解基于LangChain的大模型记忆方案。

1. 安装记忆的原理

1.1. 核心步骤

给LLM安装记忆的核心步骤就3个:

- 在对话之前调取之前的历史消息。

- 将历史消息填充到Prompt里。

- 对话结束后,继续将历史消息保存到到memory记忆中。

1.2. 常规使用方法的弊端

了解这3个核心步骤后,在开发过程中,就需要手动写代码实现这3步,这也比较麻烦,不仅代码冗余,而且容易遗漏这些模板代码。

为了让开发者聚焦于业务实现,LangChain贴心地封装了这一整套实现。使用方式如下。

2. 记忆的种类

记忆分为 短时记忆 和 长时记忆。

在LangChain中使用

ConversationBufferMemory

作为短时记忆的组件,实际上就是以键值对的方式将消息存在内存中。

如果碰到较长的对话,一般使用

ConversationSummaryMemory

对上下文进行总结,再交给大模型。或者使用

ConversationTokenBufferMemory

基于固定的token数量进行内存刷新。

如果想对记忆进行长时间的存储,则可以使用向量数据库进行存储(比如FAISS、Chroma等),或者存储到Redis、Elasticsearch中。

下面以

ConversationBufferMemory

为例,对如何快速安装记忆做个实践。

3. 给LLM安装记忆 — 非MessagesPlaceholder

3.1. ConversationBufferMemory使用示例

使用

ConversationBufferMemory

进行记住上下文:

memory = ConversationBufferMemory()

memory.save_context(

{"input": "你好,我的名字是半支烟,我是一个程序员"}, {"output": "你好,半支烟"}

)

memory.load_memory_variables({})

3.2. LLMChain+ConversationBufferMemory使用示例

# prompt模板

template = """

你是一个对话机器人,以下<history>标签中是AI与人类的历史对话记录,请你参考历史上下文,回答用户输入的问题。

历史对话:

<history>

{customize_chat_history}

</history>

人类:{human_input}

机器人:

"""

prompt = PromptTemplate(

template=template,

input_variables=["customize_chat_history", "human_input"],

)

memory = ConversationBufferMemory(

memory_key="customize_chat_history",

)

model = ChatOpenAI(

model="gpt-3.5-turbo",

)

chain = LLMChain(

llm=model,

memory=memory,

prompt=prompt,

verbose=True,

)

chain.predict(human_input="你知道我的名字吗?")

# chain.predict(human_input="我叫半支烟,我是一名程序员")

# chain.predict(human_input="你知道我的名字吗?")

此时,已经给LLM安装上记忆了,免去了我们写那3步核心的模板代码。

对于

PromptTemplate

使用以上方式,但

ChatPromptTemplate

因为有多角色,所以需要使用

MessagesPlaceholder

。具体使用方式如下。

4. 给LLM安装记忆 — MessagesPlaceholder

MessagesPlaceholder

主要就是用于

ChatPromptTemplate

场景。

ChatPromptTemplate

模式下,需要有固定的格式。

4.1. PromptTemplate和ChatPromptTemplate区别

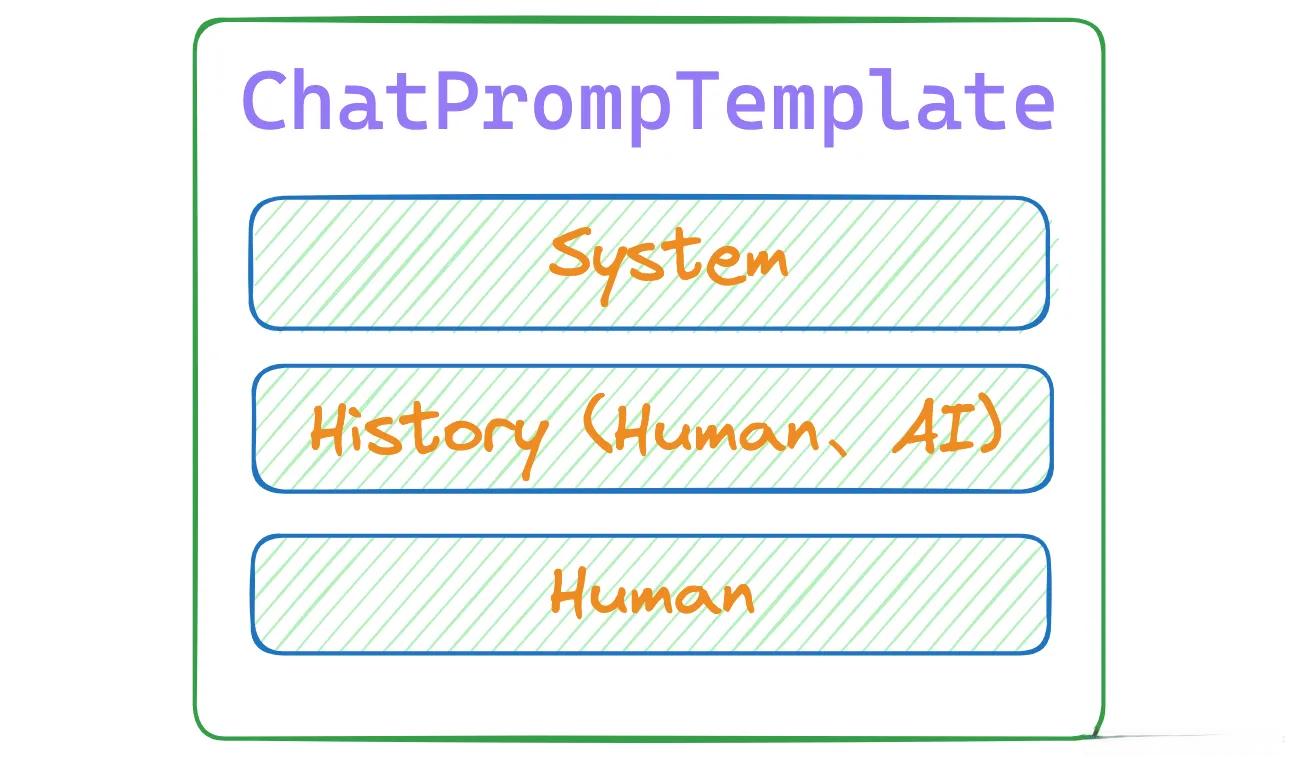

ChatPromptTemplate

主要用于聊天场景。

ChatPromptTemplate

有多角色,第一个是System角色,后续的是Human与AI角色。因为需要有记忆,所以之前的历史消息要放在最新问题的上方。

4.2. 使用MessagesPlaceholder安装

最终的ChatPromptTemplate + MessagesPlaceholder代码如下:

chat_prompt = ChatPromptTemplate.from_messages(

[

("system", "你是一个乐于助人的助手。"),

MessagesPlaceholder(variable_name="customize_chat_history"),

("human", "{human_input}"),

]

)

memory = ConversationBufferMemory(

memory_key="customize_chat_history",

return_messages=True,

)

model = ChatOpenAI(

model="gpt-3.5-turbo",

)

chain = LLMChain(

llm=model,

memory=memory,

prompt=chat_prompt,

verbose=True,

)

chain.predict(human_input="你好,我叫半支烟,我是一名程序员。")

至此,我们使用了

ChatPromptTemplate

简化了构建prompt的过程。

5. 使用对话链ConversationChain

如果连

ChatPromptTemplate

都懒得写了,那直接使用对话链

ConversationChain

,让一切变得更简单。实践代码如下:

memory = ConversationBufferMemory(

memory_key="history", # 此处的占位符必须是history

return_messages=True,

)

model = ChatOpenAI(

model="gpt-3.5-turbo",

)

chain = ConversationChain(

llm=model,

memory=memory,

verbose=True,

)

chain.predict(input="你好,我叫半支烟,我是一名程序员。") # 此处的变量必须是input

ConversationChain提供了包含AI角色和人类角色的对话摘要格式。ConversationChain实际上是对Memory和LLMChain和ChatPrompt进行了封装,简化了初始化Memory和构建ChatPromptTemplate的步骤。

6. ConversationBufferMemory

6.1. memory_key

ConversationBufferMemory

有一个入参是

memory_key

,表示内存中存储的本轮对话的

键

,后续可以根据

键

找到对应的值。

6.2. 使用"chat_history"还是"history"

ConversationBufferMemory

的

memory_key

,有些资料里是设置是

memory_key="history"

,有些资料里是

"chat_history"

。

这里有2个规则,如下:

- 在使用

MessagesPlaceholder

和

ConversationBufferMemory

时,

MessagesPlaceholder

的

variable_name

和

ConversationBufferMemory

的

memory_key

可以自定义,只要相同就可以。比如这样:

chat_prompt = ChatPromptTemplate.from_messages(

[

("system", "你是一个乐于助人的助手。"),

MessagesPlaceholder(variable_name="customize_chat_history"),

("human", "{input}"),

]

)

memory = ConversationBufferMemory(

memory_key="customize_chat_history", # 此处的占位符可以是自定义

return_messages=True,

)

model = ChatOpenAI(

model="gpt-3.5-turbo",

)

chain = ConversationChain(

llm=model,

memory=memory,

prompt=chat_prompt,

verbose=True,

)

chain.predict(input="你好,我叫半支烟,我是一名程序员。") # 此处的变量必须是input

- 如果只是使用

ConversationChain

,又没有使用

MessagesPlaceholder

的场景下,ConversationBufferMemory的memory_key,必须用

history

。

7. MessagesPlaceholder的使用场景

MessagesPlaceholder

其实就是在与AI对话过程中的

Prompt

的一部分,它代表

Prompt

中的历史消息这部分。它提供了一种结构化和可配置的方式来处理这些消息列表,使得在构建复杂

Prompt

时更加灵活和高效。

说白了它就是个占位符,相当于把从memory读取的历史消息插入到这个占位符里了。

比如这样,就可以表示之前的历史对话消息:

chat_prompt = ChatPromptTemplate.from_messages(

[

("system", "你是一个乐于助人的助手。"),

MessagesPlaceholder(variable_name="customize_chat_history"),

("human", "{human_input}"),

]

)

是否需要使用MessagesPlaceholder,记住2个原则:

- PromptTemplate

类型的模板,无需使用MessagesPlaceholder - ChatPromptTemplate

类型的聊天模板,需要使用MessagesPlaceholder。但是在使用ConversationChain时,可以省去创建ChatPromptTemplate的过程(也可以不省去)。省去和不省去在输出过程中有些区别,如下:

8. 总结

本文主要聊了安装记忆的基本原理、快速给LLM安装记忆、

ConversationBufferMemory

、

MessagesPlaceholder

的使用、对话链

ConversationChain

的使用和原理。